OpenAI Akui Masalah Serius 'Halusinasi' AI, Ungkap Penyebabnya

OpenAI mengakui masalah 'halusinasi' pada model bahasa AI-nya, di mana sistem menghasilkan informasi yang salah namun meyakinkan. Perusahaan menjelaskan bahwa masalah ini berakar pada cara model dilatih dan dievaluasi, yang sering mendorong AI untuk menebak daripada mengakui ketidakpastian. Meskipun model terbaru seperti GPT-5 menunjukkan pengurangan halusinasi, OpenAI menekankan perlunya merevisi kerangka evaluasi untuk mengatasi masalah ini secara efektif.

Berita Terbaru

WhatsApp Uji Coba Fitur Baru: Batasi Pesan untuk Tekan Spam

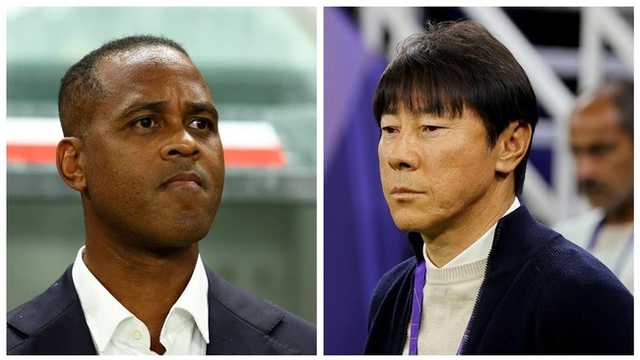

Erick Thohir: Shin Tae Yong dan Kluivert Masa Lalu Timnas Indonesia

Pemkab Sidoarjo Sanksi Pegawai Terlibat Pesta Seks Gay 'Siwalan Party'

NATO: Jet Tempur Rusia Ditembak Jatuh Hanya Jika Ancam Wilayah

Koleksi Gene Hackman Dilelang, Anak Tak Dapat Warisan

Menkeu Purbaya: Sistem Coretax Kualitas Lulusan SMA, Indonesia 'Dikibulin' Asing

Apple Lewati iPhone 19, Siapkan iPhone 20 untuk Ulang Tahun ke-20

Barcelona Resah: Cedera Lamine Yamal Ancam El Clasico

Bahlil Ungkap: Proyek Gas Masela Siap Tender EPC 2026

Kapal Pengungsi Tenggelam di Laut Aegea, 14 Orang Tewas